二.神经网络

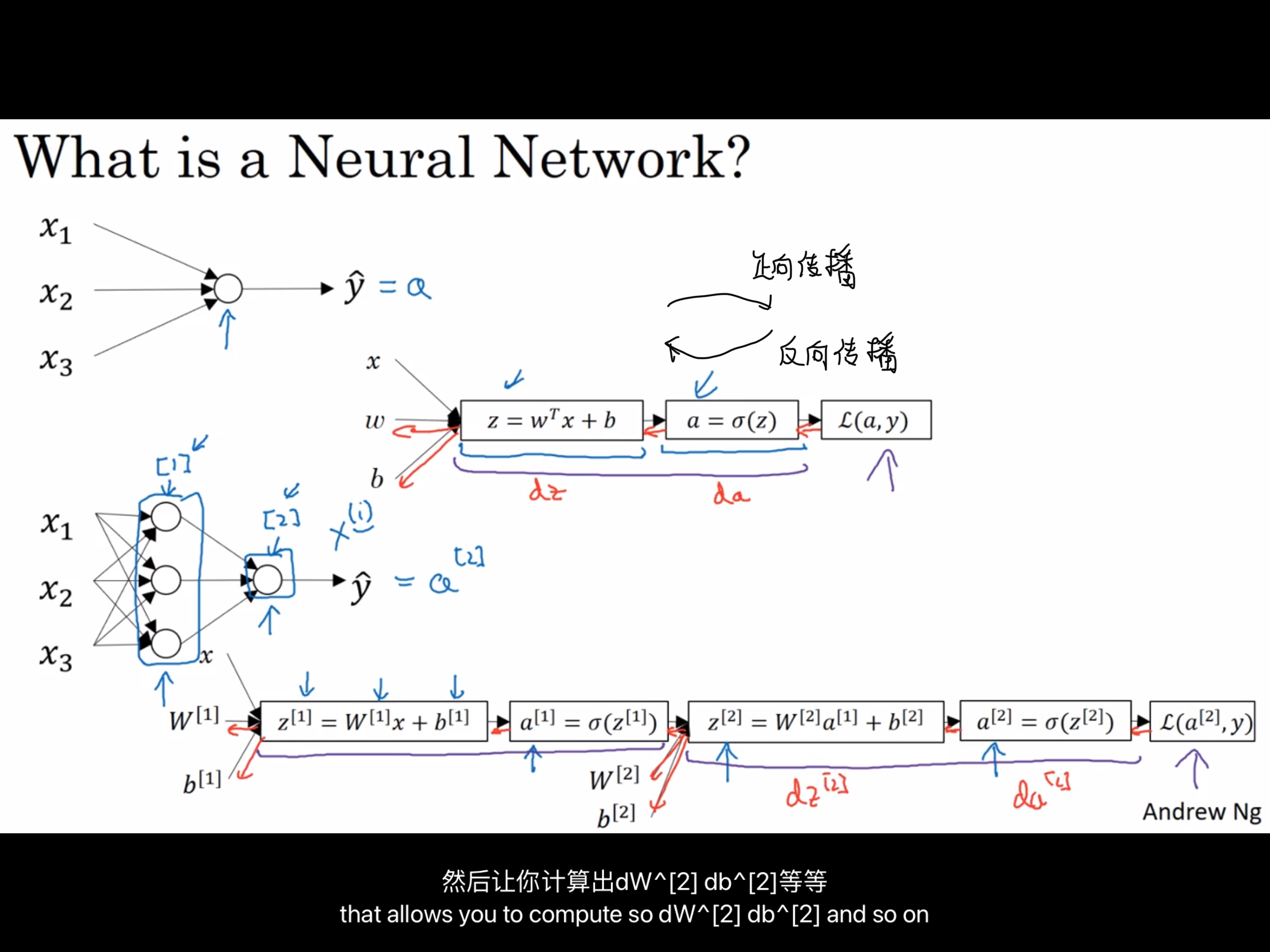

1.回顾Logistic回归:

内容,输入,z= wTx+b,传导求sigmoid函数,接着求损失函数L(正向传播);接着由损失函数,求导da,再由da求导dz,最后由dz求导回头计算dw,db等这些输入内容

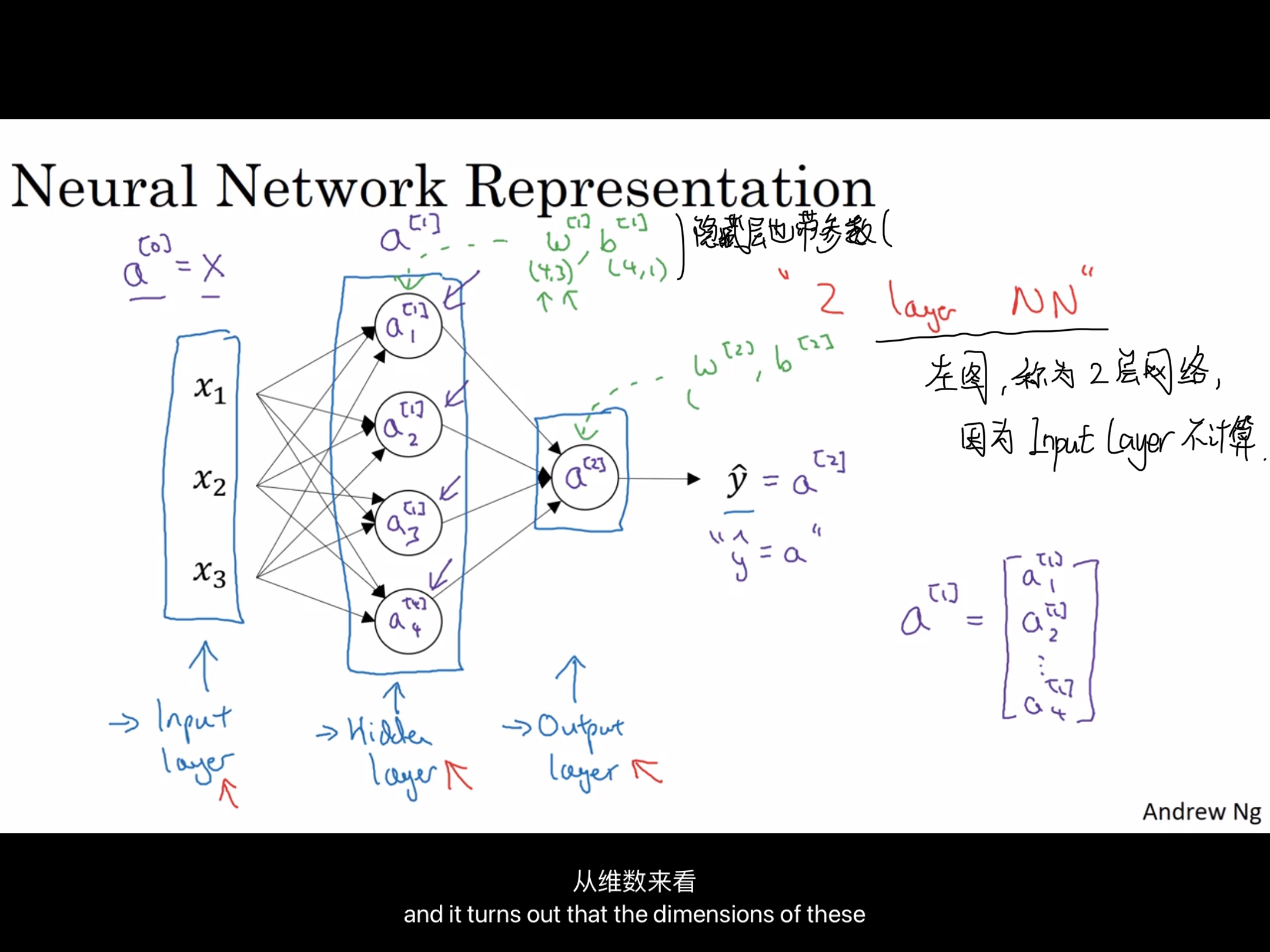

一个神经网络包含的层:

至少包括一个 输入层(Input layer),一个隐藏层(Hidden layer),一个输出层(Output layer);

- 输入层:输入参数的层,用来输入多组的X

- 输出层:输出参数的层,用来输出唯一的Y帽

- 隐藏层:再训练集中,这些中间结点的真正数值我们是不知道的,在训练集中无法查看其数据,只能看到输入值和输出值。

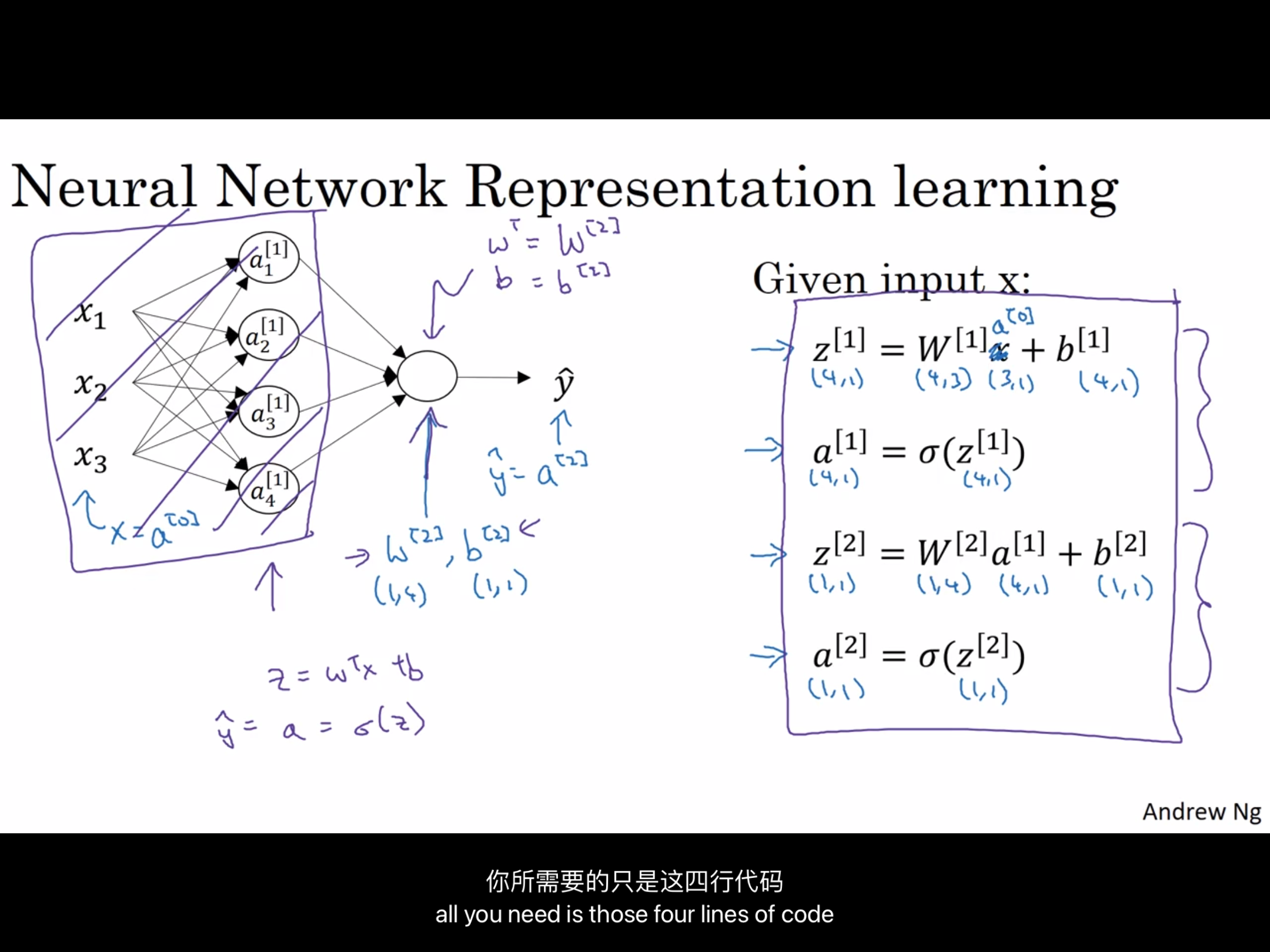

X作为输入层:可以用a[0]代替,这个a也表示“激活”(activations)的意思,意味着网络中不同层的值会传递给后面的隐藏层,

隐藏层同样会产生一些激活值,我们将其记作a[1],(本图中a[1]是一个四维的向量)

输出层可以用a[2]代替,只有一个输出层(有些时候也会约定俗成的直接y = a这样表示,不带上标)

s:每一层用一个上标表示,可以比较清晰明了的明确多少层,多少内容;

PS:输入层算作第0层,所以本图是一个双层网络。

PPS:隐藏层和输出层都是有参数的,回忆一下前面学的w和b,这些参数也会包含进入网络中

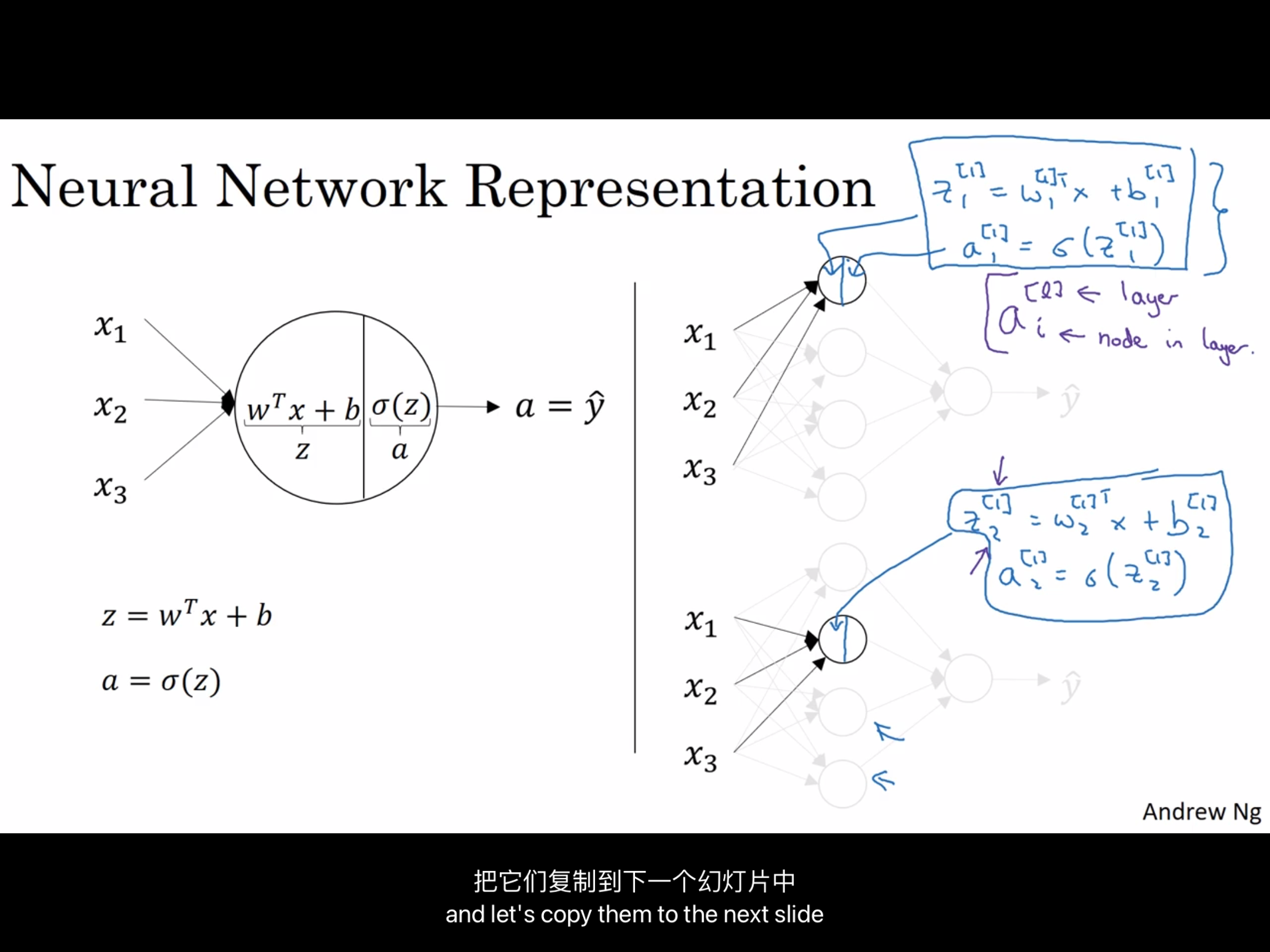

a上标表示第几层,下标表示第几个单元;

2.神经网络的输出

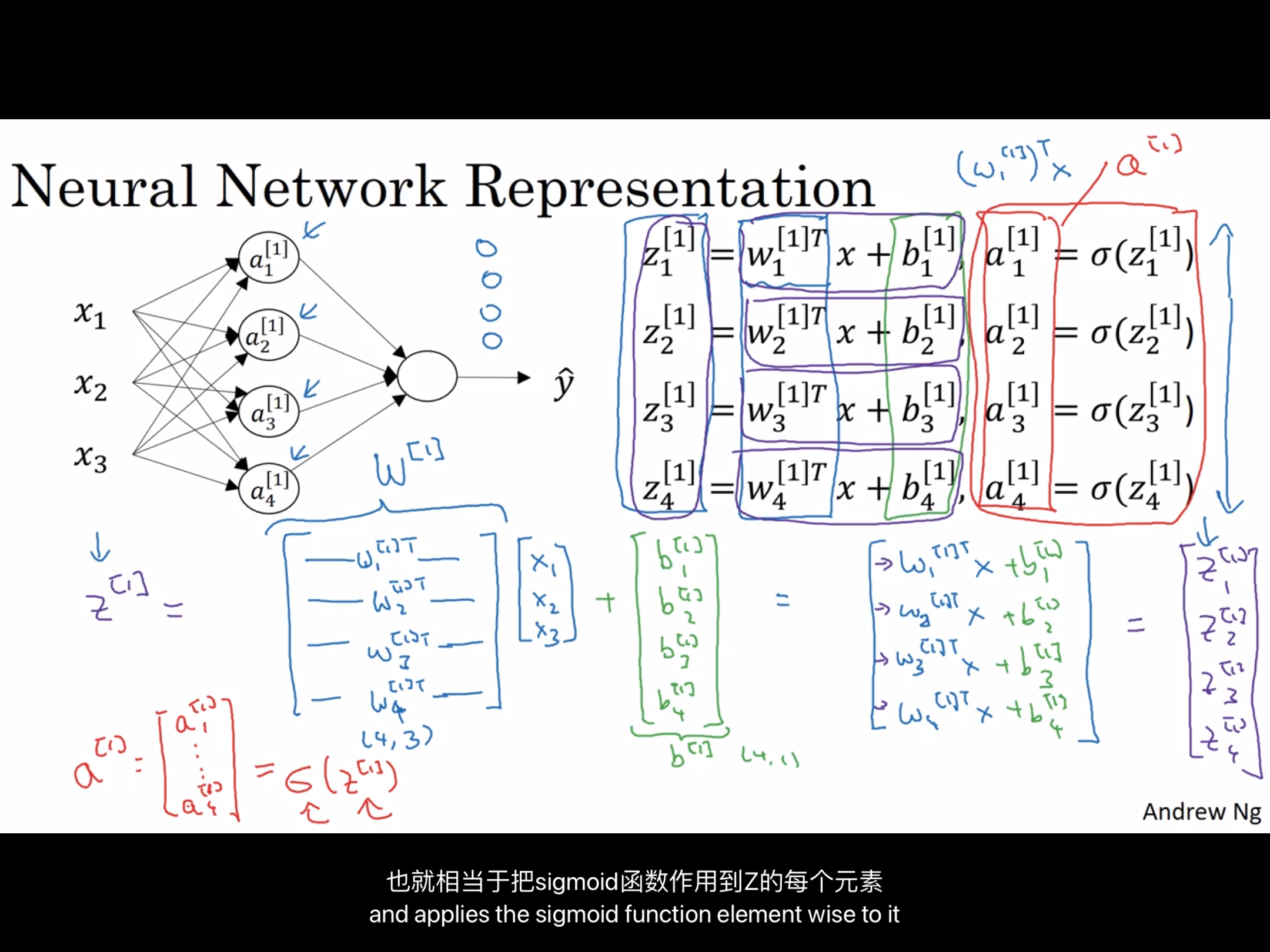

如前面所反复提出的,把全部过程的计算的值,提取出来就可以用矩阵直接进行计算,特别快,线性代数NB

最后利用矩阵,就可以利用numpy把整个计算化简成为如下大致的四行代码(伪代码)

3.多个样本的向量化

0 条评论